引言

2023年4月11日,国家网信办发布了《生成式人工智能服务管理办法(征求意见稿)》(以下简称“《办法(征求意见稿)》”)。在征集并综合考量各方意见后,网信办联合发改委、教育部、科技部、工信部、广电总局于2023年7月10日正式发布《生成式人工智能服务管理暂行办法》(以下简称“《暂行办法》”)。作为全球范围内首部直接针对生成式人工智能进行规制的国家层面法律文件,《暂行办法》将于2023年8月15日正式施行,我国人工智能敏捷治理管理模式初见成效。

此前,在《办法(征求意见稿)》发布后,我们结合其内容曾对于人工智能大语言模型相关的数据合规风险进行了分析,并为企业开展生成式人工智能开发运营与接入应用业务提出了合规建议(详见《人工智能大语言模型开发与应用的数据合规风险及其应对——兼论〈生成式人工智能服务管理办法(征求意见稿)〉合规要点》)。此次《暂行办法》相较于《办法(征求意见稿)》,对于存在模糊或仍有争议的部分进行了修订,对于合规义务的逻辑与结构进行了调整,并完善了监管原则、术语定义等部分内容,修改篇幅占全文比重较大,对于相关行业企业提出了新的合规要求,也对于从业人员与机构提供了新的启示。

本文中,我们将以数据合规的视角为中心,从《暂行办法》的修改内容、治理原则、合规要点与关键概念等方向入手,对于《暂行办法》进行多方位的解读,以期为相关企业与从业人员研发、提供与使用生成式人工智能服务提供数据合规视角下的初步参考。

一、修改点导览

从结构上来看,《暂行办法》相对于《办法(征求意见稿)》增加了章节层次,将全文划分为总则、技术发展与治理、服务规范、监督检查与法律责任,以及附则5个章节,全文逻辑更加规范清晰。

在“第一章 总则”中,针对较为重要的适用范围(第二条)、监管原则(第三条)与一般性规定(第四条)进行了修改与调整。

1. 《暂行办法》第二条关于适用范围的厘清,主要体现如下:

- 适用范围的定义以“服务”为中心,以“公众”与“境内”为要素;

- 新增规定“未向境内公众提供生成式人工智能服务”不适用《暂行办法》,在一定程度上将自主研发、内部应用、不对外公开的生成式人工智能模型排除在了规制范围之外——但值得注意的是,即便技术本身不直接面向外部公众,但如果技术本身并非自主研发,仍有可能被认定为生成式人工智能服务使用者而受到《暂行办法》的规制。

- 将《办法(征求意见稿)》中的“人工智能产品”修改为定义更加清晰的“人工智能技术”,并对于所规制的服务范围进行了非穷尽式列举,厘清了适用范围的边界。

2. 《暂行办法》第三条重塑了治理原则,尤其引人注目的是增添了“包容审慎与分类分级监管”的原则,与“第四章 监督检查和法律责任”中第十六条第二款新增的对于“创新发展科学监管方式”“制定分类分级监管规则或指引”的监管要求相呼应,采取了对于人工智能监管的风险分类分级路径,从立法到实践呼吁落实执行。关于治理原则的具体解读,详见本文第二部分“《暂行办法》的合规治理原则”。

3. 《暂行办法》第四条对于一般性规定的实质内容修改不多,但将一般性规定的规制范围从“提供生成式人工智能产品或服务”的行为扩展为“提供和使用生成式人工智能服务”的行为——结合第二十二条“生成式人工智能服务提供者”(以下简称“提供者”)与“生成式人工智能服务使用者”(以下简称“使用者”)的定义,这一改动不仅要求使用者与提供者须履行相同的一般性义务,也扩展了《暂行办法》的属事管辖权。

在“第二章 技术发展与治理”中,《暂行办法》主要增添了(现)第五条与第六条鼓励生成式人工智能发展、协作、创新与共享的“软”规则,充分体现了治理原则中“包容审慎监管”的基本要求。其中第六条第二款关于“公共训练数据资源平台建设”与“公共数据分类分级有序开放”的要求,也正是响应了《中共中央、国务院关于构建数据基础制度更好发挥数据要素作用的意见》关于发挥数据要素方面的国家顶层战略。

在“第三章 服务规范”中,值得注意的是新增关于网络信息安全与个人信息保护方面要求、使用者个人信息保护义务的规定,以及对安全事件响应与投诉举报机制进行的更新。

4. 《暂行办法》第九条新将提供者的“内容生产者责任”修改为现有法规中已有明确规定的“网络信息内容生产者责任”。根据《网络信息内容生态治理规定》,网络信息内容生产者,是指制作、复制、发布网络信息内容的组织或者个人;网络信息内容生产者不得制作、复制、发布违法信息,并应当采取措施,防范和抵制制作、复制、发布不良信息。这一修改限缩了未来对于提供者内容生产者责任的解释空间,明确了责任边界。另外,第九条还对于网络信息安全义务与个人信息保护义务作出了一般性规定,并要求提供者与使用者签订服务协议。

5. 《暂行办法》第十四条修订了有关违法内容、违法活动的响应与处置措施的要求;第十五条新增了关于投诉、举报机制,以及受理响应投诉、举报的要求。《暂行办法》在违法内容处置的基础上新增了针对违法活动的响应要求,并删去了违法内容处置中3个月的时间限制;将投诉接受处理机制修改为投诉、举报机制。另外,针对安全事件响应与投诉、举报机制,《暂行办法》均新增了向有关主管部门报告的义务。

在“第四章 监督检查和法律责任”中,较为引人注意的是新增了多部门联合管理、分类分级监管的机制,修订了关于算法备案与安全评估要求,以及新增了域外适用条款。

6. 《暂行办法》第十六条要求各相关部门依职责加强对于生成式人工智能的管理,并对于第三条的分类分级监管的治理原则进行呼应,要求相关部门完善创新监管方式,制定分类分级监管规则或指引。

7. 《暂行办法》第十七条修订了《办法(征求意见稿)》中算法备案义务覆盖范围的模糊性规定,在“生成式人工智能服务”前添加了“提供具有舆论属性或者社会动员能力”的限定词,与《互联网信息服务深度合成管理规定》(以下简称“《深度合成规定》”)以及《互联网信息服务算法推荐管理规定》(以下简称“《算法推荐规定》”)的相关规则保持一致,避免算法备案义务过度扩张对于人工智能产业发展造成阻碍,同时也与分类分级的监管原则保持一致。

8. 《暂行办法》第二十条新增了域外适用相关规定,采取了间接管辖模式,即通过对位于人工智能产业链下游的境内提供者/使用者开展管理与处罚,限制不符合《暂行规定》的境外生成式人工智能服务在境内的接入与使用。

在“第五章 附则”中,值得关注的是新增了几项重要定义。

9. 《暂行办法》第二十二条对于“生成式人工智能技术”“生成式人工智能服务提供者”,以及“生成式人工智能服务使用者”均明确了具体定义。

二、监管治理原则

《暂行办法》第三条规定,国家“对生成式人工智能服务实行包容审慎和分类分级监管”,第十六条要求有关主管部门“完善与创新发展相适应的科学监管方式,制定相应的分类分级监管规则或者指引”。

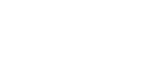

虽然《暂行办法》并未对如何进行人工智能服务或技术分类分级提供完整的规定,但考虑到近年来人工智能领域密集的立法动态、立法计划与标准制定计划,我们或许可以期待在不久后的政策法规或国家标准中找到关于人工智能技术和/或服务分类分级的具体指引。而当国内相关法规与标准处于尚待完善的阶段,欧盟《人工智能法案》(Artificial Intelligence Act)草案中基于风险水平的评估或许对于人工智能系统的分类分级实践具有一定参考意义。

《人工智能法案》草案中将人工智能系统的风险划分为“不可接受的风险(Unacceptable Risk)”“高风险(High Risk)”“有限的风险(Limited Risk)”及“低或轻微的风险(Low or Minimum Risk)”。对于被划分为不可接受风险的人工智能系统,禁止其进入市场并进行应用;对于被划分为高风险的人工智能系统,开发者应采取严格的监管措施,并在投放市场之前以及在产品运营的整个生命周期内接受安全评估;对于被划分为有限风险的人工智能系统,则要求其必须遵循透明度原则,评估和减少可能的风险,并在欧盟市场发布前应在欧盟数据库中进行注册;对于被划分为低或轻微风险的人工智能系统,可不将其列入监管范围[1]。

图1 《人工智能法案》草案下的监管框架示意图[2]

(1)《人工智能法案》草案下不可接受的风险主要包括:①在公共场所的实时远程生物识别系统;②事后远程生物识别系统(唯一的例外是在经过司法机关授权后用于起诉严重犯罪的执法部门);③使用个人敏感特征(如性别、种族、民族、公民身份、宗教、政治倾向)的生物识别分类系统;④预测性治安系统(基于分析、位置或过去的犯罪行为进行预测);⑤用于执法、边境管理、工作场所和教育机构的情感识别系统;以及⑥从互联网或监控录像中无差别地采集面部图像,以建立面部识别数据库(导致侵犯人权和隐私权)。[3]

(2)《人工智能法案》草案下高风险的人工智能系统主要指对安全或基本权利有负面影响的人工智能系统,该等人工智能系统大致包括两类:

- 针对欧盟产品安全立法(the EU’s product safety legislation)所规制产品中使用的人工智能系统,包括玩具、航空、汽车、医疗设备和电梯。

- 属于以下八个特定领域并必须在欧盟数据库中注册的人工智能系统,包括:①自然人的生物特征识别与分类;②关键基础设施的管理和运行;③教育和职业培训;④就业与员工管理;⑤个人基本服务、公共服务和福利;⑥执法;⑦移民管理和边境控制;⑧法律解释与法律适用方面的协助。[4]

三、合规义务分析

根据美国国家标准与技术研究院(National Institute of Standards and Technology,“NIST”)2023年公布的人工智能风险管理框架(Artificial Intelligence Risk Management Framework),人工智能全生命周期主要包括:规划设计(Plan and Design)、数据收集和处理(Collect and process data)、模型建立和使用(Build and use model)、检查与验证(Verify and validate)、部署和使用(Deploy and Use)、运营和监控(Operate and Monitor)。[5]

图2 人工智能系统的生命周期和关键维度示意图[6]

结合上述划分和我国《新一代人工智能伦理规范》,以及《网络安全标准实践指南—人工智能伦理安全风险防范指引》,我国将人工智能全生命周期活动大致分为:①研究开发;②设计制造;③部署应用;以及④用户使用等四大环节。以下,我们将根据人工智能生命周期活动,对《暂行办法》中涉及“提供者”的合规义务要点进行初步拆解与分析。

(一) 研究开发阶段

1. 训练数据来源与质量保证

人工智能的研究和开发离不开对数据的收集与训练使用。因此,从第一个环节开始,就需要对人工智能模型的“养料”——训练数据的收集和使用进行规制。

根据《暂行办法》第七条,提供者应当依法开展预训练、优化训练等训练数据处理活动,在处理活动中遵守以下规定:①使用具有合法来源的数据和基础模型;②涉及知识产权的,不得侵害他人依法享有的知识产权;③涉及个人信息的,应当取得个人同意或者符合法律、行政法规规定的其他情形;④采取有效措施提高训练数据质量,增强训练数据的真实性、准确性、客观性、多样性;⑤符合《中华人民共和国网络安全法》《中华人民共和国数据安全法》《中华人民共和国个人信息保护法》等法律、行政法规和其他有关规定以及有关主管部门的通知和相关监管要求。针对义务已遵守的符合性内容,相关企业可以提供有效证明且保持记录完整、真实、准确。

根据《暂行办法》第八条,在生成式人工智能技术研发过程中需要进行数据标注的,提供者应当制定符合本办法要求的清晰、具体、可操作的标注规则;同步开展数据标注质量评估,抽样核验标注内容的准确性;并提前对标注人员进行必要的培训,提升遵法守法意识,监督指导标注人员规范开展标注工作。如有出现违规标注行为的,可以通过内部纪律和操作指引对相关人员进行警告、降级、停职等处分。

(二) 设计制造阶段

与Privacy by Design机制类似,在人工智能服务制造阶段,如何将合规要求融入到产品设计中,实现“AI Compliance by Design”,是提供者在这一环节中的需要实现的主要目标。

1. 使用者权益保护

根据《暂行办法》第九条,提供者所提供服务内容涉及个人信息的,应依法承担个人信息处理者责任,履行个人信息保护义务,应当与注册其服务的生成式人工智能服务使用者签订服务协议,明确双方权利义务。

为实现使用者的权益保护,特别是对其个人信息权益的保护,提供者在设计产品的过程中不仅需要通过外部协议来明确权利义务,还需要通过对产品进行精准定位,明确受众群体、范围和使用必要个人信息的范围,并且为使用者提供切实可落地的行权路径。具体要求为:

- 根据《暂行办法》第十条,提供者应当明确并公开其服务的适用人群、场合、用途,指导使用者科学理性地认识和依法使用生成式人工智能技术,采取有效措施防范未成年人用户过度依赖或者沉迷生成式人工智能服务。

- 根据《暂行办法》第十一条,提供者对使用者输入的信息和使用记录应当依法履行保护义务,不得收集非必要的个人信息;不得非法留存能够识别使用者身份的输入信息和使用记录;不得非法向他人提供使用者的输入信息和使用记录;应当依法及时受理和处理个人关于查阅、复制、更正、补充、删除其个人信息等请求。

2. 建立响应机制

除了主动保护使用者权益外,提供者应当同时向使用者提供便捷的投诉举报方式,以便使用者更直接和主动地能够维护其合法权益。根据《暂行办法》第十五条,提供者应当建立健全投诉、举报机制,设置便捷的投诉、举报入口,公布处理流程和反馈时限,及时受理、处理公众投诉举报并反馈处理结果。

(三) 部署应用阶段

1. 深度合成内容标识

根据《暂行办法》第十二条,提供者应当按照《互联网信息服务深度合成管理规定》(以下简称“《深度合成规定》”)对图片、视频等生成内容进行标识。对于如何进行标识和需要标识的场景,可以进一步参考《深度合成规定》中的内容:

- 根据《深度合成规定》第十六条,深度合成服务提供者对使用其服务生成或者编辑的信息内容,应当采取技术措施,添加不影响用户使用的标识,并依照法律、行政法规和国家有关规定保存日志信息。

- 根据《深度合成规定》第十七条,深度合成服务提供者提供以下深度合成服务,可能导致公众混淆或者误认的,应当在生成或者编辑信息内容的合理位置、区域进行显著标识,向公众提示深度合成的情况,包括:(一)智能对话、智能写作等模拟自然人进行文本的生成或者编辑服务;(二)合成人声、仿声等语音生成或者显著改变个人身份特征的编辑服务;(三)人脸生成、人脸替换、人脸操控、姿态操控等人物图像、视频生成或者显著改变个人身份特征的编辑服务;(四)沉浸式拟真场景等生成或者编辑服务;(五)其他具有生成或者显著改变信息内容功能的服务。深度合成服务提供者提供其他深度合成服务的,应当提供显著标识功能,并提示深度合成服务使用者可以进行显著标识。

2. 算法备案与安全评估

根据《暂行办法》第十七条,提供具有舆论属性或者社会动员能力的生成式人工智能服务的,应当按照国家有关规定开展安全评估,并按照《互联网信息服务算法推荐管理规定》(以下简称“《算法推荐规定》”)履行算法备案和变更、注销备案手续。

根据《算法推荐规定》第二十四条,具有舆论属性[7]或者社会动员能力的算法推荐服务提供者应当在提供服务之日起十个工作日内通过互联网信息服务算法备案系统填报服务提供者的名称、服务形式、应用领域、算法类型、算法自评估报告、拟公示内容等信息,履行备案手续。算法推荐服务提供者的备案信息发生变更的,应当在变更之日起十个工作日内办理变更手续。算法推荐服务提供者终止服务的,应当在终止服务之日起二十个工作日内办理注销备案手续,并作出妥善安排。

根据《算法推荐规定》第二十五条,完成备案的算法推荐服务提供者应当在其对外提供服务的网站、应用程序等的显著位置标明其备案编号并提供公示信息链接。

图3 算法备案系统入口界面[8]

(四) 用户使用阶段

1. 服务保障与内容监督

当人工智能服务投入运营之后,提供者一方面需要保障产品的正常运营和用户的正常使用;另一方面,基于我国目前对于人工智能侧重内容监管的趋势,提供者应当同时对服务/产品中是否存在违法违规内容进行实时监督和处置。

《暂行办法》第十三条规定,提供者应当在其服务过程中,提供安全、稳定、持续的服务,保障用户正常使用。

根据《暂行办法》第十四条,提供者发现违法内容的,应当及时采取停止生成、停止传输、消除等处置措施,采取模型优化训练等措施进行整改,并向有关主管部门报告。提供者发现使用者利用生成式人工智能服务从事违法活动的,应当依法依约采取警示、限制功能、暂停或者终止向其提供服务等处置措施,保存有关记录,并向有关主管部门报告。

另外,需要特别说明的是,我们曾在《人工智能大语言模型开发与应用的数据合规风险及其应对——兼论〈生成式人工智能服务管理办法(征求意见稿)〉合规要点》一文中将人工智能模型的应用模式划分为“内部应用模式”与“外部应用模式”:①“内部应用模式”下,企业基于内部目的使用生成式人工智能技术,技术本身不直接面向外部用户/客户,但技术生成的内容或提供的策略可能会在经营与销售中使用;②“外部应用模式”下,企业基于外部目的使用生成式人工智能技术,技术本身直接面向外部客户或用户提供服务(包括面向外部用户经营To C业务,及面向外部客户经营To B业务)。结合《暂行办法》中对于“提供者”和“使用者”的定义,如果某企业处于人工智能生命周期及产业链上下游链条的中间位置,例如企业本身不研发预训练模型或大模型,而是通过API等方式借助第三方研发的产品和/或技术向用户提供服务,那么则面临着相对特殊的合规处境——如果其采用“内部应用模式”则更可能被归类为“使用者”,而如果采用“外部应用模式”则更可能被归类为“提供者”。因此,建议这类企业需要同时履行“提供者”和“使用者”双重的合规义务。

针对“使用者”的合规义务,《暂行办法》并没有单独的特殊要求,而是通过第四条,将“提供者”与“使用者”需要履行的原则性要求进行了统一规定,具体包括以下五点:

四、 关键概念提要

无论是作为ChatGPT基础的GPT-3/GPT-4、Google的PaLM/PaLM-E、Meta的LLaMA,还是国内人工智能企业所自研的生成式人工智能模型,它们都可以被概括为“生成式预训练大模型”。从技术之外的角度出发,对于以下几个概念的简单说明有助于我们进一步厘清《暂行办法》的规制对象。

- 自然语言处理(Natural Language Processing, NLP)是语言学、计算机科学和人工智能共同的跨学科分支领域,涉及计算机和人类语言之间的互动,即对计算机进行编程以处理、分析大量的自然语言数据[9],其目的为理解(并生成可被理解的)自然语言。[10]

- 预训练模型(Pre-Trained Model, PTM),也称为生成式预训练(Generative Pre-Training)模型,是先使用大量的无标注数据(Unlabeled Data)基于语言模型目标进行无监督预训练(Unsupervised Pre-Training),得到一个包含高容量初始参数的基础语言模型;随后在基础模型之上,使用标注数据(Labeled Data)基于应用任务的具体特性构建判别性任务(Discriminative Task),并通过有监督训练(Supervised Training)的方式进行微调(Fine-tuning),最终得到一个用于特定处理目的的语言模型。[11]

- 大模型(Large-Scale Model),是由于具备大规模参数而产生了涌现能力(Emergent Ability)的语言模型。涌现能力是在较小规模的模型中不存在且不能被预测,但在较大规模的模型中存在的能力。[12]涌现能力往往打破比例原则(Scaling Law)而使得其无法通过对于较小规模模型的观察进行预测。涌现能力的出现与计算量、模型参数数量以及训练数据集的大小有关——在上述参数的规模较小时,随着参数的增长,模型的表现符合比例原则并接近于随机分布;而在参数规模超过某一阈值后,模型表现会提升到远高于随机的程度。[13]

- 生成模型(Generative Model)是用于完成自然语言生成任务的语言模型。如前所述,自然语言处理的所有任务类型可以大致分为自然语言理解(包括文本分类、自动问答)与自然语言生成(机器翻译、文本摘要),[14]而Google研究人员提出的T5 (Text-to-Text Transfer Transformer)模型在预训练模型的基础上,进一步将自然语言理解任务与自然语言生成任务统一转化为条件式生成任务,将相同的文本到文本模型、训练目标、训练程序和解码过程应用于各类自然语言处理任务。[15]

- 多模态学习(Multimodal Learning)是指使用同一个模型/系统对不同类型、不同来源、不同形式的信息进行分析与输出。广义上的多模态能力包括多语言融合、多媒体融合与异构知识融合。[16]其中,多媒体融合多模态能力使得模型拥有对包含文字、图像、音频、视频在内的多种传播媒介的输入输出能力,并可能拥有跨媒介的输入输出能力。

综上,目前主流的生成式人工智能模型是“以自然语言处理为目的、以统一生成模型为基础、具备多模态学习能力的预训练大语言模型”。

结语

从《具有舆论属性或社会动员能力的互联网信息服务安全评估规定》《互联网信息服务算法推荐管理规定》到《互联网信息服务深度合成管理规定》,再到此次公布的《暂行规定》,我国在算法、人工智能领域监管的顶层设计日益完善。国务院办公厅于2023年5月31日发布(6月6日向社会公布)的《国务院2023年度立法工作计划》附件中,明确将《人工智能法草案》列为“预备提请全国人大常委会审议”的法律案——人工智能监管的上位立法提上日程,使得《新一代人工智能发展规划》中“分三步走”的战略目标在政策法规制定层面的路径愈发清晰,而对于人工智能监管原则的理解跃而成为企业,特别是科技企业合规思路的重中之重。

不断更新修订的法规内容为人工智能产业带来了全新的合规挑战,而快速发展的人工智能技术同时为法律法规的建立健全提出了更加紧迫的要求。面对人工智能领域新的技术、新的实践、新的规则与新的思路,全球都在进行着积极探索,而《暂行规定》的出台则意味着我国迈出了坚实的第一步:以内容合规为监管出发点,吸收借鉴境内外监管思路与经验,以风险评估与分类分级为基础,健全完善监管体系。与此同时,无论是生成式人工智能产品/服务的提供方还是直接使用方,抑或是中间链条的接入方,均需要对于生成式人工智能监管的理解更上一个台阶,在人工智能技术生命周期的每一个环节中落实合规义务,在合规中求发展,在发展中保合规。

在逆全球化风头渐盛、世界局势不确定性渐强的当下,各国政府、相关企业与从业人员在人工智能发展与监管中的竞相跟进、共享共治,为我们展现了不确定性的历史图景中共同体光亮的一瞥——如何把握科技进步所带来的发展契机,已成为全球治理者、从业者面临的共同课题。环球同此凉热,我们更应携手共建更加安全、准确、可靠、透明的治理环境,期待为人工智能科技的发展与进步提供更多有益的中国方案。

注释:

[1] Briefing: Artificial Intelligence Act, European Parliamentary Research Service, https://www.europarl.europa.eu/RegData/etudes/BRIE/2021/698792/EPRS_BRI(2021)698792_EN.pdf.

[2] Id.

[3] MEPs ready to negotiate first-ever rules for safe and transparent AI, European Parliament (June 14, 2023), https://www.europarl.europa.eu/news/en/press-room/20230609IPR96212/meps-ready-to-negotiate-first-ever-rules-for-safe-and-transparent-ai.

[4] EU AI Act: first regulation on artificial intelligence, European Parliament (June 14, 2023), https://www.europarl.europa.eu/news/en/headlines/society/20230601STO93804/eu-ai-act-first-regulation-on-artificial-intelligence.

[5] Artificial Intelligence Risk Management Framework, NIST, https://nvlpubs.nist.gov/nistpubs/ai/NIST.AI.100-1.pdf

[6] Id.

[7] 根据《具有舆论属性或社会动员能力的互联网信息服务安全评估规定》第二条,具有舆论属性或社会动员能力的互联网信息服务,包括下列情形:

(一)开办论坛、博客、微博客、聊天室、通讯群组、公众账号、短视频、网络直播、信息分享、小程序等信息服务或者附设相应功能;

(二)开办提供公众舆论表达渠道或者具有发动社会公众从事特定活动能力的其他互联网信息服务。

[8] https://beian.cac.gov.cn/#/home

[9] Natural language processing, Wikipedia, https://en.wikipedia.org/wiki/Natural_language_processing.

[10] 一般认为,自然语言处理的概念最早见于艾伦·麦席森·图灵(Alan Mathison Turing)于1950年10月发表于期刊Mind的著名论文《计算机器与智能》(Computing Machinery and Intelligence)。在这篇论文中,图灵不仅通过“模仿游戏(The Imitation Game)”的情景提出了著名的“图灵测试(The Turing Test)”,还选定了去特征化的自然语言文本作为这一测试的媒介,使得“机器可以思考吗?(Can machines think?)”这一问题的回答指向了以下2个命题:(1)机器是否可以准确理解人类语言,以及(2)机器是否可以准确生成能被理解的人类语言。而这2个命题正是自然语言处理中的自然语言理解(Natural Language Understanding, NLU)技术和自然语言生成(Natural Language Generation, NLG)技术所希望达成的目标。Turing, A. M. (1950). Computing Machinery and Intelligence. Mind, 59, 433, 433-6.

[11] Radford, A., Narasimhan, K., Salimans, T. & Sutskever, I. (2018). Improving language understanding by generative pre-training. 预训练模型由OpenAI团队在2018年发表的初代GPT论文《使用生成式预训练提升语言理解》(Improving Language Understanding by Generative Pre-Training)中首次提出,并随着Google团队开发的BERT (Bidirectional Encoder Representation from Transformer)等预训练模型的陆续出现,在近年来获得了长足发展。预训练模型主要是为了解决自然语言处理中各类任务之间的壁垒问题。它可以使得搭建一个面向特定任务的模型不再需要了解非常多的任务背景,而只需要根据任务的输入输出形式微调并应用预训练得到的基础语言模型。同时,无监督预训练与监督微调结合的方式也很好地解决了无标注数据的使用困难,提高了数据利用的效率。

[12] Wei, J., Tay, Y., et al. (2022). Emergent abilities of large language models. Transactions on Machine Learning Research, 08, 1, 2.

[13] Id.

[14] 车万翔,郭江,崔一鸣,《自然语言处理:基于预训练模型的方法》,北京:电子工业出版社(2021),第257页。

[15] Raffel, C., Shazeer, N., et al. (2020). Exploring the limits of transfer learning with a unified text-to-text transformer. Journal of Machine Learning Research, 21, 1, 2-3.

[16] 车万翔,郭江,崔一鸣(2021),第270-284页。一般认为,人工智能的发展分为以下三个方向:计算智能(Computational Intelligence)、感知智能(Perceptual Intelligence)和认知智能(Cognitive Intelligence),Shi, P. (2022). Research on the strategy of autonomous learning under the dual-class model of ideological and political courses based on the knowledge map route. Wireless Communications and Mobile Computing, 2022, 1, 3. 计算智能主要指计算机进行快速计算和存储的能力;感知智能主要指机器的多模态信息识别能力,主要包括对视觉、听觉和触觉的感知能力;认知智能主要指机器对于抽象化信息(如,语言文本)的理解、推理、解释的能力。而目前不断出现的具备多模态能力(尤其是图片和视频能力)的大语言模型,则逐渐模糊了感知智能与认知智能之间的边界,使得大语言模型逐渐走向所谓的通用人工智能(Artificial General Intelligence, AGI)。